导读:在物理学当中,物理学家们经过近百年的努力,找到了一种理论模型,能够合理解释电磁相互作用、强相互作用和弱相互作用所导致的所有物理现象,这被称为“大统一理论”(Grand Unified Theory)。这种大统一理论也成为物理学家们继续迈向“万有理论”的一个基石。

于是,人们不仅要问——人工智能是否也存在一个所谓的“大统一理论”呢?

这一问题的提出有着重要的意义,这代表着有一部分人尝试从统一理论的角度追寻智能的本质。一批智源学者尝试就这一问题,给出了自己的回答。北京大学林伟教授首先做了引导报告,随后邓柯、林伟、林宙辰、明平兵、王涵、文再文、张志华等人围绕“人工智能的大统一理论?”这一主题的几个问题进行讨论。林伟:

今天邀请七位专家,从几个不同的理论的层面来对人工智能数理基础进行讨论。

由我先抛砖引玉,做一个引导报告。我们探讨的主题是“人工智能的大统一理论?”

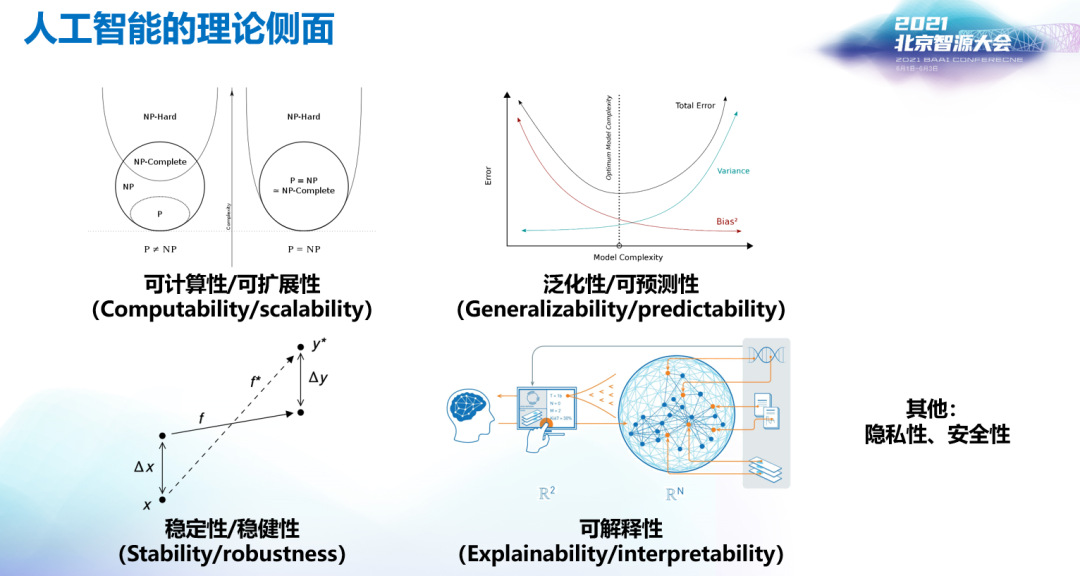

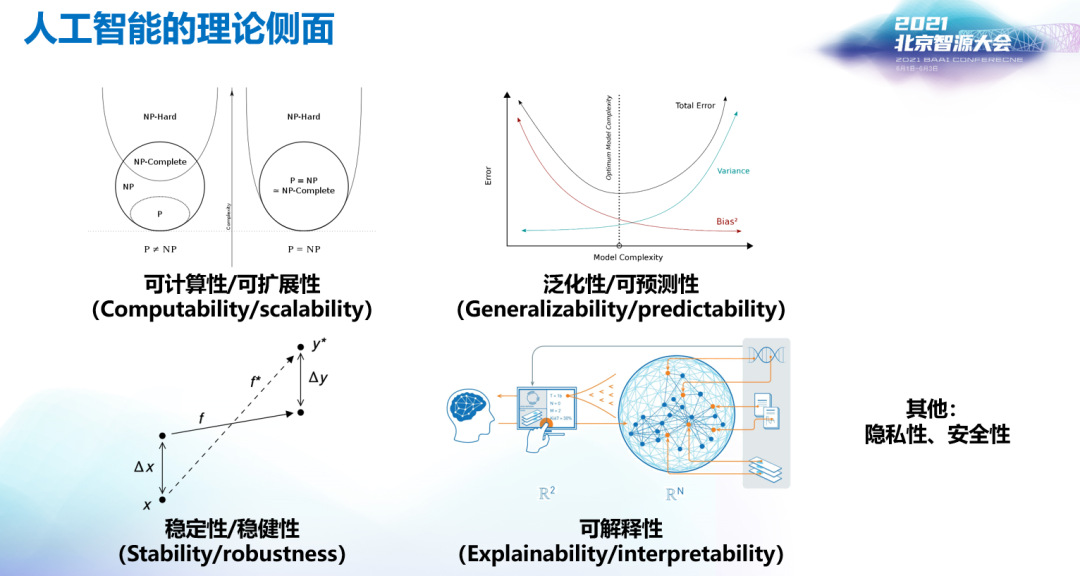

现在人工智能的应用已经非常广泛,但美中不足的一点是缺乏一点点理论。何为人工智能的理论呢?它到底有哪些方面?从我个人的角度,我觉得最主要的包括以下侧面。

第一个侧面是可计算性或可扩展性。可计算性是一个比较基本的要求。一个学习算法能够实现的前提是计算复杂度不大,且能够可扩展至大规模应用场景。这个侧面是运筹学和优化等方面研究的重点。

第二个侧面是泛化性或者可预测性。这是一个比较核心的问题,它能够保证有关的学习算法在未观测的数据集上也能表现的很好。这个侧面是统计学等研究的重点。

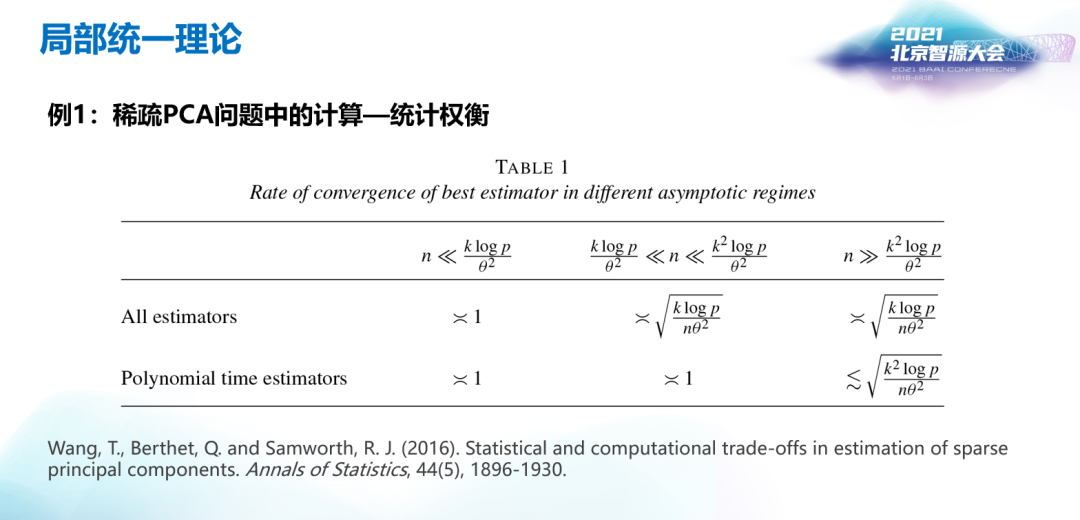

第三个侧面是稳定性或者是稳健性。稳定性在机器学习领域常指算法的稳定性,它关心的问题是当我们对模型或者算法作出一定的扰动时,其输出是否在可控的范围内。另外一方面是统计方面的稳健性,它关心的问题是当我们对分布作出一定的扰动时,我们得到的预测值或者对参数的估计值是否仍然有效。第四个侧面是可解释性。可解释性关心的问题是如何理解我们得到的模型或者算法的工作原理或者机制,甚至理解生成数据背后的机制。可解释性是启发未来人工智能方法的关键之一。其他还有隐私性、安全性等侧面,也很重要,这里我就不多说了。回到我们今天的问题上,实际上我们并不是没有理论,而是有非常多的理论。被大家广泛分享的爱因斯坦说过的一句话:如果我要建立一个新的理论,不是要放火把房子烧了重建一个新的摩天大楼,而是更像爬山。现在人工智能的理论,如果按照四个侧面,那么实际上就有四个小山包,每个小山包基本上都有人占领。但到底哪个小山包更有希望,我们目前并不是很清楚。如果能够建立一个大统一的理论,从更加高、宽泛的视角来看待这些似乎割裂着的理论,进而在这些不同的理论侧面建立一个深刻的联系,这不仅可以帮助我们更本质的理解人工智能现阶段各个方法的本质,还有助于指导我们发展新的更好更“智能”的算法。第一个例子是计算和统计之间的权衡。我们知道,算法需要有多项式算法或更好地复杂度;但另一方面我们希望它在统计上的效率要好一些。这两方面实际上是需要某种程度的平衡。Wang et al. (2016)[1]这篇工作,介绍了稀疏主成分估计问题中统计和计算之间的权衡。如果不考虑算法的复杂度,估计稀疏的主成分会随着样本量增大发生相变:随着样本量逐渐增大并超过一个阶,从一个平凡的估计误差突变到最优的速率。而如果我们把算法局限在多项式复杂度时,这个相变会发生改变,而且无论样本量如何增加都不能达到最优的估计收敛速度。第二个例子是泛化性和稳定性之间的关系。我们知道稳定性实际上,在某种意义上跟泛化性有很深刻的联系,因为所谓的泛化就是怎样从训练集到测试集之间的结果再现,这相当于你在数据集上做一个小的扰动,所以它实际上跟稳定性是相关的。这里我给一个比较经典的工作Bousquet et al. (2002)[2],是怎样用稳定性的几种定义来推泛化的界:一个算法越稳定,那么把训练的样本改变成独立同分布的新样本对输出的影响就越小,那么这个算法就泛化的越好。第三个例子是预测和可解释性之间的权衡关系。Yang (2005)[3]曾指出,预测和变量选择之间不能同时达到最优:如果想要以最优的预测作为标准选择超参数,那么对应的变量选择(可解释性)的结果就不是最优的;而如果以最准确的变量选择作为标准选择超参数,那么对应模型的预测能力就不是最好的。第四个例子是隐私和效率之间的关系(Duchi et al., 2018)[4]。该文指出,如果想要实现一定的隐私保护任务,那么算法的效率将会被牺牲。一个世纪以前,物理学发生了天翻地覆的变化,短时间内就出现了相对论和量子力学两种物理学理论。在这一百年的进程中,物理学家们一直在苦苦追求所谓一种万有理论,统一所有的物理现象。但似乎截止目前为止,也只有所谓的“大统一理论”,统一了电磁相互作用、强相互作用和弱相互作用三种,而没有包含引力作用。

我们再来看数学,偏微分方程有一些理论,特别是非线性的偏微分方程是否存在一般的理论,目前还存在一些争论。

那么人工智能是否能够发展出“大统一理论”呢?这个我也不知道,我列出四个问题供大家讨论:- 人工智能是一个统一的学科亦或一系列相关学科的紧密/松散的联合?

- 人工智能的几大研究范式/基础理论/实现手段是否存在统一的可能性?

问题一:人工智能是一个统一的学科亦或一系列相关学科的紧密/松散的联合?明平兵教授认为人工智能领域就像数学里的非线性偏微分方程一样,没有一个统一的理论,各个研究主题之间像是一座又一座孤立的小岛。非线性偏微分方程没有一个统一的研究方法,但是有一些一般性的概念、方法和技巧,如适定性和解的正则性等。这些一般但是不普适的方法随着众多数学家的努力推动,已经联系得十分紧密。因此给人工智能领域的启发就是,虽然我们没有一个统一的理论,但是可以发展一些一般性的概念、方法和技巧,并让它们之间深入地交融在一起。文再文教授认为,人工智能有关的问题大多可以转化为一个优化问题,但是具体的问题之间又存在着较强的个人倾向性,因此很难说人工智能是一个统一的学科。邓柯教授认为,目前人工智能距离大统一理论还比较遥远,现状仍是一个比较松散的联合。人工智能的领域十分宽泛,如算法、机器学习、认知科学、神经科学、知识图谱等。大家各自做的工作差异非常大,各具特色。目前机器学习领域发展的非常快,研究范式一直在更新,其理论发展具有非常大的可塑性。从一个统一的观点来看待统计等数据学科和类脑科学是一件十分有意义的事情,但是实现起来还是有很大难度的。林宙辰教授认为,联系的紧密与否需要相对的来看。相邻的两个领域联系紧密,但是存在着联系不紧密的领域。人工智能领域好比是一个链条,上下游联系的紧密,之外的就不紧密。比如统计——机器学习——计算机视觉——多媒体等。上游领域的突破往往会极大的促进下游学科的发展。这个紧密性是动态的。比如计算机视觉和自然语言处理之间是在深度学习兴起之后才紧密联系在一起的。张志华教授认为,目前人工智能主要还在机器学习的范畴里。要想有一个大统一的理论,建立一个大统一的模型是很值得期待的。而要想建立一个大统一的模型,那么首先要从数学上定义什么算智能,就像信息论里的熵一样。王涵教授认为,机器学习的理论方法目前在自然科学里发挥着越来越重要的作用,机器学习也能够解决自然科学里建模遇到的各种各样的困难。但是自然科学领域建立的模型,由于要满足各种各样物理约束,和机器学习常用的模型存在着较大差别。这会给机器学习领域带来各自各样的问题和需求。问题二:人工智能的几大研究范式/基础理论/实现手段是否存在统一的可能性?明平兵教授认为统一人工智能或者是机器学习的研究范式目前没有可能实现,其实也没有那么紧迫去做这件事。至于能否把因果推断和机器学习的方法统一在一起,我们还需要看时间、看进展、看将来应用场景对理论研究的推动。文再文教授认为,在比较抽象的层次大统一理论是十分困难的。但如果我们聚焦在一些小领域,比如说强化学习领域,是存在着统一的可能性的。强化学习里有一个十分著名的Bellman方程。基于Bellman方程的policy-iteration在线性规划问题中等价于单纯形法。深度学习和强化学习结合的深度强化学习的很多算法,比如Q-learning,都依赖于Bellman方程。因此小领域之间更容易发展出一个统一的理论。邓柯教授认为,在中观和微观的尺度构建一个统一的理论还是大有可为的。比如在统计学中高维函数的估计是存在着维数灾难的。但在深度学习中普遍的高维数据相关的实践中,我们得到的结果是比传统统计声称的收敛速度要好很多的。这说明机器学习方法用到了传统统计没有假设的特征。我们可以从新的视角来分析经典统计所作的假设。从中观的层次来讲,怎么把数据驱动和知识驱动结合起来,怎么把大规模的知识表示和数据信息结合起来,这都是人工智能领域未来发展的一个重要方向。在更宏观的层次上,把以算法为核心的人工智能和类脑科学、神经科学方面的研究结合在一起。可以畅想未来某一天神经科学和类脑科学取得了重大突破,让我们更本质的理解大脑的运转机制,这一定会对我们算法为核心的方向产生巨大的影响和推动作用。宏观尺度上虽然能保持乐观的期待,但是在微观和中观尺度我们还是能作出一些工作来推进统一理论的发展的。林宙辰教授认为,我们想要统一人工智能,首先要定义什么是大统一,我们要统一什么?在物理学中,人们要统一的方面是十分明确的,就是四种作用力。那么在人工智能领域,我们要统一的方向是什么呢?只有把要统一的东西用数学表示或者严格的定义出来,我们才会有建立起统一理论的希望。事实上,物理学的大统一理论也是在各个小领域之间统一的基础之上才逐渐明确的。那么我们也可以先在各个小领域之间做好工作,大家建立起一个共识。其次,如果要统一一个理论,那么就要有一个人或者一个团体把各个方面都要了解清楚,但目前来讲这是不可能的。从抽象的意义上,我相信大统一理论是一定存在的,只是我们要给出一个构造性的证明。问题三:现阶段/将来有必要追求人工智能的大统一理论吗?林伟教授指出,人工智能最开始是基于符号主义的,而现在大家是基于数据去做机器学习,但基于数据的机器学习很难去做一些常识的推理,所以大家会想往符号主义回归,把符号主义好的东西融合进机器学习里来。因此他提出:机器学习有关的理论和符号逻辑有关的理论能否建立在一个统一的框架中?另外,各个领域之间能否存在一个公共的“语言”,例如邓柯更倾向于贝叶斯学派,林伟偏向频率学派,但是他们之间可以通过Bernstein-von-Mises定理建立联系。林宙辰教授认为大家对“理论”的定义并不一样。林伟所指的理论是“是否存在一个共同的pattern”,但林宙辰认为他说倾向的“理论”应该是演绎,即能否通过演绎把整个框架演绎出来。前者是从实际的角度来考虑,而后者是从方法论的层面考虑。张志华教授认为,符号主义和基于数据的机器学习理论之间并不矛盾。如果是简单的问题,是可以通过符号主义来解决的,但是对于复杂的问题会存在类似于维数灾难的现象,使得利用符号主义的方法不可行。后来的基于数据的连接主义可以说是对符号主义的一个近似,这样我们就可以来把问题解决。但是如果某一天计算复杂度不需要考虑了,我们完全返回符号主义。所以这个问题本质上还是如何克服维数灾难。关于统一理论,如果我们可以把智能用数学语言定义出来,就像信息论里的熵一样,那么我们就可以通过最大化“智能”来设计算法,进一步把这个最大化智能的算法的稳定性、可解释性等全部解决了。但是目前我们的目标函数还是最小二乘或者交叉熵,但是最小化距离不代表最大化智能。我们说的人工智能其实最关心的是算法。王涵教授认为,如果我们给一个智能体一些基本的知识,那么它能否自己做归纳、实验,乃至于重现人类目前的知识体系,甚至发现新的知识。这个或许就是对智能的终极检验。明平兵教授认为,维数灾难是一个很重要的具体问题。从抽象的角度来讲,如何从一个数学的角度来严格形式化人工智能的问题是很困难的。文再文教授认为,我们可以用的数学工具太少,可能是因为人工智能领域太年轻了。正如20世纪初的物理学一样,后来引入了更多的数学工具取得了十分迅速的发展。邓柯教授认为,我们目前缺少一个整体性的框架。目前我们研究的范式就是最小化一个目标函数。但是如果这个问题具有很复杂的不确定性,只是最小化目标函数难以捕捉到这些不确定性。我们可能在用一个简单的方法来解决一个复杂的问题,故而缺少一个切中要害的理论框架。林伟教授认为,我们目前对非凸优化了解的不够多,如何做非凸优化的算法的泛化性的理论保证还缺乏一个统一的手段。另外一个角度是符号主义和机器学习结合的问题。数理逻辑之间的关系是严格的,确定的。但是在不确定性的影响下,因果关系不总能传递。那么我们只能从一个整体的角度来研究它们之间的关系。邓柯教授认为,不确定性会导致十分深刻的变化,但我们缺乏有效的方法和手段分析它。林宙辰教授认为,我们能用的数学工具还是不够多。从牛顿发明微积分以来,我们都是从局部出发来研究问题。但是每个局部都分析的很好,不代表整体也能分析的很好。统计力学是一个整体性分析的例子,它引入了全局的变量,如温度、压力,进而分析整个系统的变化。这给我们一个启发,就是能否定义一个全局的参数,然后研究整体的性质。张志华教授认为,现状的理论发展还是很丰富的,但是大家对理论不够满意的原因可能在于理论对于实践的指导还不够好。现在有一个新的思路是说,统计和优化之间需要重新看待。之前优化只是统计的一个工具,用来取得全局最小值。但是现在优化不仅仅只是一个计算工具,而更像是一个方法论。那么从这个视角来研究问题或许能取得一些进展。王涵教授指出了一个新的问题。目前机器学习模型落地的时候用的数值的精度都是很低的。之前科学计算的数值精度都是64精度,但是现在单精度都不够,甚至是半精度或二值的。在这种近似下,已有的数学理论是很难指导调参的。这个时候由于精度不够产生的误差怎么建模、怎么分析,可能是一个值得研究的问题。

本文来源:智源社区